Netskopeの調査研究部門であるNetskope Threat Labsは、企業のAIアプリ利用に関する新たな調査レポート「クラウド・脅威レポート:企業におけるAIアプリ」を発表した。このレポートによれば、生成AIアプリケーションに共有されるビジネス上の機密情報の3分の1以上が規制対象の個人データであり、企業にとって大きなリスクとなっていることが明らかになった。

調査結果の概要

Netskope Threat Labsの最新調査によると、企業の4分の3は少なくとも1つの生成AIアプリを完全にブロックしている。しかし、データセントリックな管理策を適用している組織は半数以下にとどまり、DLP(データ損失防止)ソリューションの導入が遅れている企業が多数を占める。

生成AIの利用拡大

調査対象企業の96%が生成AIを使用しており、この数は過去12カ月で3倍に増加した。企業は平均で10近くの生成AIアプリを使用しており、生成AIアプリの採用数で上位1%にあたる企業では平均して80のアプリを使用している。また、生成AIアプリ内での機密ソースコードの共有が急増し、データポリシー違反の46%を占める状況となっている。

企業のリスク管理の現状

調査結果からは、65%の企業がリアルタイムのユーザーコーチングを導入しており、57%のユーザーは警告を受けた後に行動を変更していることが示された。これにより、データに関連するリスクの軽減に効果があることがわかる。

Netskopeの見解

NetskopeのCISOであるジェームズ・ロビンソン氏は、「生成AIの安全性を確保するにはさらなる投資と注意が必要である」と述べ、企業のデータ、評判、ビジネスの継続性を保護するために、強固なリスク管理アプローチの必要性を強調した。

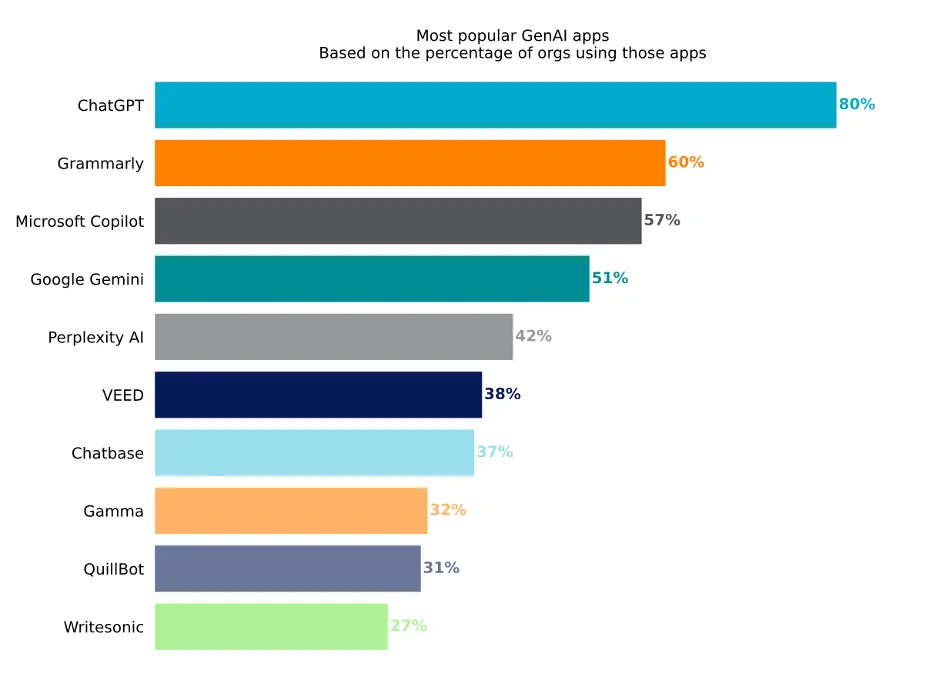

最も人気の高い生成AIアプリ

調査では、ChatGPTが最も人気の高い生成AIアプリであり、80%以上の企業が利用していることがわかった。Microsoft Copilotはリリース以来57%の利用率を示し、GitHub CoPilotは19%の企業で利用が全面禁止されている。

企業への推奨事項

Netskopeは各企業に対し、NISTのAIリスク管理フレームワークなどを活用し、AIや生成AIに特化したリスク管理フレームワークの見直しと適用を推奨している。具体的には、現状の評価、コアコントロールの実施、高度なセキュリティ管理の計画策定、そして定期的なセキュリティ対策の有効性評価を行うことが重要だとしている。